О корреляции вообще (и в частности о линейной как раз) см. вопрос № 36 с. 56 (64) 063.JPG

КОЭФФИЦИЕНТ КОРРЕЛЯЦИИ г-ПИРСОНА

r-Пирсона (Pearson r) применяется для изучения взаимосвязи двух метрических переменных, измеренных на одной и той же выборке. Существует множество ситуаций, в которых уместно его применение. Влияет ли интеллект на успеваемость на старших курсах университета? Связан ли размер заработной платы работника с его доброжелательностью к коллегам? Влияет ли настроение школьника на успешность решения сложной арифметической задачи? Для ответа на подобные вопросы исследователь должен измерить два интересующих его показателя у каждого члена выборки. Данные для изучения взаимосвязи затем сводятся в таблицу, как в приведенном ниже примере.

ПРИМЕР 6.1

В таблице приведен пример исходных данных измерения двух показателей интеллекта (вербального и невербального) у 20 учащихся 8-го класса.

Связь между этими переменными можно изобразить при помощи диаграммы рассеивания (см. рис. 6.3). Диаграмма показывает, что существует некоторая взаимосвязь измеренных показателей: чем больше значения вербального интеллекта, тем (преимущественно) больше значения невербального интеллекта.

Прежде чем дать формулу коэффициента корреляции, попробуем проследить логику ее возникновения, используя данные примера 6.1. Положение каждой /-точки (испытуемого с номером /) на диаграмме рассеивания относительно остальных точек (рис. 6.3) может быть задано величинами и знаками отклонений соответствующих значений переменных от своих средних величин: (xj — MJ и (у, —Му). Если знаки этих отклонений совпадают, то это свидетельствует в пользу положительной взаимосвязи (большим значениям по х соответствуют большие значения по у или меньшим значениям по х соответствуют меньшие значения по у).

Для испытуемого № 1 отклонение от среднего по х и по у положительное, а для испытуемого № 3 и то и другое отклонения отрицательные. Следовательно, данные того и другого свидетельствуют о положительной взаимосвязи изучаемых признаков. Напротив, если знаки отклонений от средних по х и по у различаются, то это будет свидетельствовать об отрицательной взаимосвязи между признаками. Так, для испытуемого № 4 отклонение от среднего по х является отрицательным, по у — положительным, а для испытуемого № 9 — наоборот.

Таким образом, если произведение отклонений (х,— Мх) х (у, — Му) положительное, то данные /-испытуемого свидетельствуют о прямой (положительной) взаимосвязи, а если отрицательное — то об обратной (отрицательной) взаимосвязи. Соответственно, если х w у ъ основном связаны прямо пропорционально, то большинство произведений отклонений будет положительным, а если они связаны обратным соотношением, то большинство произведений будет отрицательным. Следовательно, общим показателем для силы и направления взаимосвязи может служить сумма всех произведений отклонений для данной выборки:

При прямо пропорциональной связи между переменными эта величина является большой и положительной — для большинства испытуемых отклонения совпадают по знаку (большим значениям одной переменной соответствуют большие значения другой переменной и наоборот). Если же х и у имеют обратную связь, то для большинства испытуемых большим значениям одной переменной будут соответствовать меньшие значения другой переменной, т. е. знаки произведений будут отрицательными, а сумма произведений в целом будет тоже большой по абсолютной величине, но отрицательной по знаку. Если систематической связи между переменными не будет наблюдаться, то положительные слагаемые (произведения отклонений) уравновесятся отрицательными слагаемыми, и сумма всех произведений отклонений будет близка к нулю.

Чтобы сумма произведений не зависела от объема выборки, достаточно ее усреднить. Но мера взаимосвязи нас интересует не как генеральный параметр, а как вычисляемая его оценка — статистика. Поэтому, как и для формулы дисперсии, в этом случае поступим также, делим сумму произведений отклонений не на N, а на TV— 1. Получается мера связи, широко применяемая в физике и технических науках, которая называется ковариацией (Covahance):

|

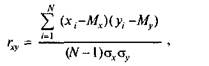

В психологии, в отличие от физики, большинство переменных измеряются в произвольных шкалах, так как психологов интересует не абсолютное значение признака, а взаимное расположение испытуемых в группе. К тому же ковариация весьма чувствительна к масштабу шкалы (дисперсии), в которой измерены признаки. Чтобы сделать меру связи независимой от единиц измерения того и другого признака, достаточно разделить ковариацию на соответствующие стандартные отклонения. Таким образом и была получена формула коэффициента корреляции К. Пирсона:

В психологии, в отличие от физики, большинство переменных измеряются в произвольных шкалах, так как психологов интересует не абсолютное значение признака, а взаимное расположение испытуемых в группе. К тому же ковариация весьма чувствительна к масштабу шкалы (дисперсии), в которой измерены признаки. Чтобы сделать меру связи независимой от единиц измерения того и другого признака, достаточно разделить ковариацию на соответствующие стандартные отклонения. Таким образом и была получена формула коэффициента корреляции К. Пирсона:

(6.1)

или, после подстановки выражений для ох и

|

Если значения той и другой переменной были преобразованы в г-значения по формуле

то формула коэффициента корреляции r-Пирсона выглядит проще (071.JPG):

N-l

http://slovari.yandex.ru/dict/sociology/article/soc/soc-0525.htm

КОРРЕЛЯЦИЯ ЛИНЕЙНАЯ - статистическая линейная связь непричинного характера между двумя количественными переменными х и у. Измеряется с помощью "коэффициента К.Л." Пирсона, который является результатом деления ковариации на стандартные отклонения обеих переменных:

,

,

где sxy - ковариация между переменными х и у;

sx, sy - стандартные отклонения для переменных х и у;

xi, yi - значения переменных х и у для объекта с номером i;

x, y - средние арифметические для переменных х и у.

Коэффициент Пирсона r может принимать значения из интервала [-1; +1]. Значение r = 0 означает отсутствие линейной связи между переменными х и у (но не исключает статистической связи нелинейной). Положительные значения коэффициента (r > 0) свидетельствуют о прямой линейной связи; чем ближе его значение к +1, тем сильнее связь статистическая прямая. Отрицательные значения коэффициента (r < 0) свидетельствуют об обратной линейной связи; чем ближе его значение к -1, тем сильнее обратная связь. Значения r = ±1 означают наличие полной линейной связи, прямой или обратной. В случае полной связи все точки с координатами (xi, yi) лежат на прямой y = a + bx.

"Коэффициент К.Л." Пирсона применяется также для измерения тесноты связи в модели регрессии линейной парной.

Дата: 2016-10-02, просмотров: 330.