1) Теорема о критической скорости:

Теорема определяет критическую скорость передачи  , зависящую только от распределения вероятности, при которой существует способ передачи со скоростью R (

, зависящую только от распределения вероятности, при которой существует способ передачи со скоростью R (  ), при котором возможно восстановление исходного сообщения (

), при котором возможно восстановление исходного сообщения (  ), где С – пропускная способность канала, Н(А) – энтропия источника;

), где С – пропускная способность канала, Н(А) – энтропия источника;

2) Теорема о кодировании:

Если H’(A) – производительность источника - меньше емкости канала (  ), то существует способ кодирования и декодирования, при котором вероятность ошибки будет сколь угодно мала

), то существует способ кодирования и декодирования, при котором вероятность ошибки будет сколь угодно мала  и наоборот.

и наоборот.

Пример расчёта скоростных характеристик для канальной матрицы источника.

1. Исходные данные

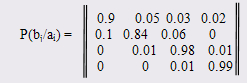

Дана матрица условных вероятностей, которые отражают действие помех дискретного канала связи.

Сумма вероятностей каждой строки равна 1,00.

Время передачи символа τ = 0,0002 сек. Передано 250 символов.

Безусловные вероятности появления символов на выходе:

p(a1)=0.25, p(a2)=0.35, p(a3)=0.15, p(a4)=0.25

2. Расчёты

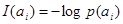

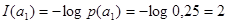

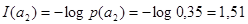

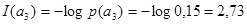

1) Количество информации I(ai )каждого символа a1, a2, a3 дискретного сообщения :

(i=1,2,3) [ бит]

(i=1,2,3) [ бит]

[бит]

[бит]

[бит]

[бит]

[бит]

[бит]

[бит]

[бит]

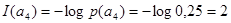

2)Среднее количество информации, переданное одним символом определяет энтропия источника сообщений Н(А):

[бит/символ]

[бит/символ]

H(A) = -(0,25*(-2) + 0,35*(- 1,51) + 0,15*(- 2,73) + 0,25*(-2) = -(-0,5 - 0,53 – 0,41 – 0,5) = 1,94 [бит/символ]

3)Максимальная энтропия источника сообщений Hmax(A)

Hmax(A)= log N=log 4=2 [бит/символ]

где N-количество символов в алфавите сообщения.

4)Информационные потери при передаче каждого символа ai определяет частная условная энтропия H(B/ai ):

[бит/символ]

[бит/символ]

H(B/a1 )= -(0,9*(-0,15) + 0,05*(-4,32) + 0,03*(-5,05)+0,02*(-5,64) =

-(-0,1368 – 0,2161 – 0,1518 – 0,1129) = 0,6175 [бит/символ]

H(B/a2 )= -(0,1*(-3,32) + 0,84*(-0,25) + 0,06*(-4,05)+0) =

-(-0,3321 – 0,2112 – 0,2435 – 0) = 0,787 [бит/символ]

H(B/a3 )= -(0 + 0,01*(-6,64) + 0,98*(-0,03)+0,01*(-6,64)) =

-(-0 – 0,0664 – 0,0286 – 0,0664) = 0,1614 [бит/символ]

H(B/a4 )= -(0 + 0 + 0,01*(-6,64)+0,99*(-0,0145)) =

-(-0– 0 – 0,0664 – 0,0144) = 0,081 [бит/символ]

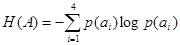

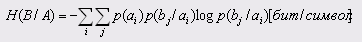

5)Средние потери информации при передаче одного символа определяет общая условная энтропия источника Н(B/А):

H(B|A) = 0,25*0,6175 + 0,35*0,787 + 0,15*0,1614 + 0,25*0,081 = 0,1543 + 0,2755 + 0,0242 + 0,02 = 0,4743 [бит/символ]

6)Общие потери информации в канале святи при передаче сообщения, состоящего из 250 символов I

I = k H (B / A) = 250,737476 = 184 [бит]

где k – количество символов в переданном сообщении.

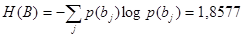

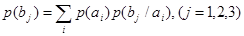

7) Среднее количество информации, принятое приемником на один символ, определяется энтропией приемника Н(B)

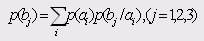

[бит/символ]

[бит/символ]

p(b1) = 0,9*0,25 + 0,35*0,1 + 0 + 0 = 0,225 + 0,035 = 0,26

p(b2) = 0,05*0,25 + 0,84*0,35 + 0,01*0,15 +0 = 0,0125+0,294+0,0015 =0,35

p(b3) = 0,03*0,25 + 0,06*0,35 + 0,98*0,15+0,01*0,25 = 0,0075+0,021+ 0,147+0,0025 = 0,178

p(b4) = 0,02*0,25 + 0 + 0,01*0,15 + 0,99*0,25 = 0,005 + 0+0,0015+ 0,2475=0,254

H(B) = -(0,26*(-1,94) + 0,35*(-1,7) + 0,178*(-2,49) + 0,254*(-1,97)) = -

-(-0,5 – 0,5234 – 0,4432 – 0,5) = 1,974 [бит/символ]

8) Максимальная энтропия приемника, Hmax(B)

Hmax(B)= log N = log 4 =2 [бит/символ]

9)Среднее количество принятой приемником информации, на один символ с учетом потерь информации, I (A, B)

I (A, B) = H (B) – H (B / A) =  -

-  = 1,5 [бит/символ]

= 1,5 [бит/символ]

10) Скорость модуляции дискретного канала, n

n=  =

=  =500 [бод]

=500 [бод]

11) Продуктивность дискретного канала сообщений, H’(A)

H’(A)=  [бод]

[бод]

H’(A) =  = 970,3227 [бод]

= 970,3227 [бод]

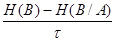

12) Скорость передачи информации, R

R =

R= (1,974 - 0,4743)/0,002 = 749,8676 [бод]

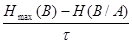

13) Пропускная способность (емкость) дискретного канала связи определяется максимальной скоростью передачи: C=max R

С=

C=  = 762,8716 [бод]

= 762,8716 [бод]

14) Коэффициент эффективности дискретного канала связи Kэ

Kэ=  =

=  =0,9829

=0,9829

15) Критическая скорость передачи Rкр

Rкр=  =

=  = 393,102 [бод]

= 393,102 [бод]

Оценка надёжности и эффективности дискретного канала связи

1. Оценка теоремы Шеннона по скорости

R<Rкр

749,8676 > 393,102

2. Оценка выполнения теоремы по кодированию

H’(A) < C

970,3227 > 762,8716

3. Рекомендации по повышению надёжности и эффективности

Из-за невыполнения теоремы о скорости передачи невозможным становится восстановление исходного сообщения. При кодировании и декодировании информации вероятность ошибки может быть сколь угодно велика. Для улучшения эффективности необходимо увеличить емкость канала С.

Теоремы Шеннона не выполняются, а значит, наш канал связи не является эффективным и надежным.

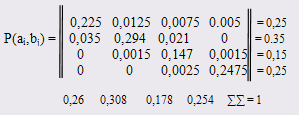

Построение канальной матрицы объединения

Найдем безусловные вероятности появления сигналов на входе приемника по формуле:

Зная КМИ можно построить КМО: р(аi,,bj)= p(ai)p(bj/аi)

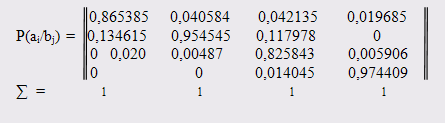

Построение канальной матрицы приемника

Зная КМО мы можем построить КМП, найдя элементы по формуле :

p(ai / bj)= p(ai,bj)/p(bj)

Часть 2. Теория кодирования

Дата: 2019-12-22, просмотров: 655.