Под сообщением понимается некоторая совокупность сведений, подлежащая передаче, т.е. объект передачи. Средством передачи сообщения является сигнал, под которым понимается некоторый физический процесс, однозначно соответствующий данному сообщению.

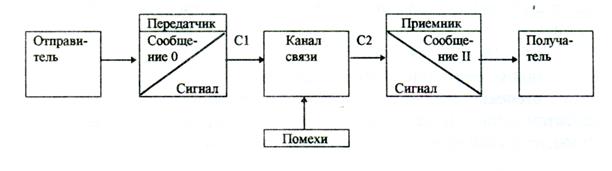

Рис. 6. Структурная схема передачи сообщения.

Структурная схема передачи сообщения представлена на рис. 6. Сообщение О, сформированное отправителем, преобразуется в передатчике в сигнал С 1 , представляющий собой, как правило, электромагнитные колебания. Сигнал С 1 поступает в канал связи (КС), под которым понимается совокупность технических средств, необходимых для передачи сигнала на большие расстояния. Сигнал С 2 с выхода КС подается в приемник, в котором происходит обратное преобразование сигнала в сообщение П, поступающее к получателю. Вследствие помех, т.е. мешающих передаче сигнала по КС на большие расстояния воздействий, сигнал С 2 не полностью соответствует сигналу С 1 , а следовательно, сообщение П может отличаться от сообщения О, что, естественно, нежелательно. Поэтому передача сообщений должна быть организована таким образом, чтобы получатель правильно понял отправителя, несмотря на наличие помех в КС, т.е. при передаче сообщений должна быть предотвращена потеря передаваемой информации.

Информация является основным содержанием сообщения, т.е. представляет собой те сведения, содержащиеся в сообщении, которые не известны получателю до получения данного сообщения. Каждое сообщение формируется, как правило, из нескольких элементов, каждый из которых может принимать качественно различные значения (качества). Пусть число элементов сообщений n , а число качеств, которое может принимать каждый элемент, - m . Тогда общее число сообщений, которые могут быть сформированы из этих элементов, составляет

N = m n . ( 1 )

Пусть, например, n = 4, m = 2.

| Генерируемая | активная | мощность электростанции | соответствует плановой |

| Генерируемая | активная | мощность энергообъединения | отличается от плановой на 50% |

Из четырех элементов при двух возможных качествах каждого элемента может быть сформировано N = 2 4 = 16 сообщений. Однако количество информации в каждом сообщении различно, т.к. диспетчер ожидает появления этих сообщений с различной вероятностью. Так, сообщение “Генерируемая активная мощность электростанции соответствует плановой” не является для диспетчера неожиданностью и не требует от него немедленных действий. Сообщение “Генерируемая активная мощность энергообъединения отличается от плановой на 50%” является для диспетчера большой новостью и требует от него активных действий по управлению энергосистемой. Следовательно, второе сообщение содержит гораздо большее количество информации по сравнению с первым.

Мера количества информации

Получение информации представляет собой процесс раскрытия неопределенности случайного события. При этом ясно, что степень неопределенности оказывается тем больше, чем большее число исходов имеет это событие, т.е. чем больше m. Т.о., степень неопределенности есть функция числа исходов, т.е. f (m). Функция f (m), характеризующая количественную меру неопределенности, должна, очевидно, удовлетворять следующим условиям:

- при m = 1 f (m) = 0;

- при возрастании m f (m) возрастает;

- степень неопределенности n (независимых) случайных событий с числом исходов соответственно m 1 , m 2 , ..., m n равняется сумме степеней неопределенности этих событий, т.е.

f (m 1 , m 2 , ..., m n ) = f (m 1 ) + f (m 2 ) + ...+ f (m n ) . ( 2 )

Английский инженер Хартли в 1928 г. предложил использовать в качестве

f (m) логарифмы m по основанию 2. В этом случае начальная неопределенность событий с m исходами может быть представлена как

h нач = log 2 m . ( 3 )

Получение информации есть уменьшение неопределенности. Количество полученной информации I равно разности между начальной h нач и оставшейся после получения информации конечной h кон неопределенностью, т.е.

I = h нач - h кон . ( 4 )

Если после получения информации неопределенность полностью раскрыта

(h кон = 0), то

I = h нач = log 2 m . ( 5 )

За единицу количества информации (бит) принимается в соответствии с ( 5 ) количество информации, содержащееся в событии с двумя равновероятными исходами ( m = 2 ).

B n событиях, каждое из которых имеет m i исходов,

( 6 )

( 6 )

Так, в примере, приведенном в предыдущем разделе в соответствии с мерой неопределенности Хартли I = 4 бит.

Мера неопределенности Хартли не учитывает уменьшение неопределенности события в случае разных вероятностей исходов этого события. С целью учета вероятности исходов события Шеннон предложил для определения степени неопределенности использовать энтропию, т.е. среднее значение неопределенности использовать энтропию, т.е. среднее значение неопределенности всех m исходов, имеющих вероятности P 1 ...P i ...I m .

Неопределенность i-го исхода

h i = - log 2 P i . ( 7 )

Среднее значение неопределенности всех m исходов, т.е. энтропия

. ( 8 )

. ( 8 )

Сравним меры неопределенности Хартли и Шеннона на примере события с двумя исходами. Пусть m = 2, вероятность первого исхода Р , вероятность второ-го исхода 1 - Р , тогда энтропия

H = - P log 2 P - (1- p) log 2 (1 - P) .

Ясно, что при Р = 0 и Р = 1 неопределенность в событии отсутствует, т.е. Н = 0, а при Р = 0.5 H = H max = 1 (рис. 7). Мера неопределенности Хартли в со-бытии с двумя исходами h = log 2 m = 1. Т.о., мера Шеннона и мера Хартли совпа-дают при равной вероятности исходов.

Количество информации, содержащееся в сообщении, согласно Шеннону, есть разность энтропии до и после получения сообщения, т.е.

I = H нач - Н кон . ( 9 )

Если сообщение полностью раскрывает неопределенность, то

. ( 10 )

. ( 10 )

Если это сообщение состоит из n элементов, каждый из которых может иметь m качеств с вероятностями Р 1 ,..., Р i ,..., P m , то

. ( 11 )

. ( 11 )

Пусть в условиях примера 1 вероятности появления разных качеств 1 и 2 элементов сообщения одинаковы, т.е. Р 11 = Р 21 = Р 12 = Р 22 = 0.5. Вероятность первого качества третьего элемента (“мощность электростанции”) Р 13 = 0.9, а второго качества третьего элемента (“мощность энергообъединения”) Р 23 = 0.1. Вероятность первого качества четвертого элемента (“соответствует плановой”)

Р 1 4 = 0.9999, а второго качества четвертого элемента (“отличается от плановой на 50%”) Р 2 4 = 0.0001. Тогда информация, содержащаяся в сообщении примера 1 будет:

I = 1 + 1 + (- 0.9 log 2 0.9 - 0.1 log 2 0.1) + (-0.9999 log 2 0.9999 - 0.0001 log 2 0.0001) @

@ 2.5 бит < 4 бит .

Мера информации Шеннона получила также название статистической меры информации.

Дата: 2019-03-05, просмотров: 332.